A/B-Tests locken mit dem Versprechen datengetriebener Entscheidungen und Ergebnissen, die direkt auf dem Verhalten der Zielgruppe basieren. Doch obwohl sie das Potenzial haben, wertvolle Einblicke zu liefern, werden sie oft zum „Shiny Object“ – glänzend, aber ohne Substanz. Warum scheitern diese Tests häufig, trotz der verlockenden Prämisse? Welche handwerklichen und analytischen Stolpersteine ziehen sich durch die Praxis?

Springen Sie direkt zu einzelnen Unterpunkten

Fehlende Hypothese & Zielsetzung

A/B-Tests bieten eine wunderbare Möglichkeit, das eigene Bauchgefühl über Kunden, deren Verhalten und Präferenzen auf den Prüfstand zu stellen. Sie ermöglichen uns, die oft trügerische Sicherheit des „Das mögen unsere Kunden bestimmt“ gegen harte Fakten einzutauschen.

Somit sollte vor jedem Test nicht nur die Frage gestellt werden: „Was wollen wir eigentlich beweisen oder widerlegen?“, sondern auch evaluiert werden, ob das geplante Testsetup tatsächlich in der Lage ist, das „Warum“ hinter den Ergebnissen zu erklären. Die Hypothese soll daher nicht nur den Test und den erwarteten Uplift definieren, sondern gleichzeitig auch unsere Vermutung für die Gründe dieses Uplifts formulieren.

Tipp für solide Hypothesen

Die eben genannten Faktoren lassen sich durch das „Wenn-Dann-Weil“-Framework abdecken. Beim Erstellen der Hypothese formulieren wir diese drei Faktoren:

WENN – Veränderung, die im Rahmen des Tests vorgenommen wird

DANN – Erwarteter Up- oder Downlift durch die Veränderung anhand einer Kennzahl

WEIL – Unsere Annahme, warum die Veränderung einen Up- oder Downlift erzeugt

Eine Hypothese könnte also so aussehen:

WENN wir unseren Newsletter um 7:00 Uhr morgens statt wie bisher um 10:00 Uhr versenden, DANN erwarten wir eine Erhöhung der Klickrate um 10%, WEIL mehr Empfänger ihr E-Mail-Postfach als erstes am Morgen checken und so unsere Nachricht priorisiert wahrnehmen.

Mikrooptimierungen statt strategischen Tests

Ohne klare Hypothese sehen sich Teams oft mit einer Flut von Testmöglichkeiten konfrontiert, was oft zu Überforderung führen kann. In dieser Situation wird häufig zum Testen oberflächlicher, inkrementeller Änderungen gegriffen. Aspekte wie Ausrufezeichen in Betreffzeilen oder minimale Änderungen in CTA-Texten werden getestet. Diese Tests sind i.d.R. zwar einfach durchzuführen, liefern aber oft keine signifikanten Verbesserungen und bieten keine tiefergehenden Einblicke in das Verhalten der Nutzer.

Diese Vorgehensweise führt selten zu Erkenntnissen, die den Marketingerfolg oder das Zielgruppenverständniss substanziell steigern können. Stattdessen gerät man leicht in einen Kreislauf unbedeutender Optimierungen oder statistisch nicht signifikanter Ergebnisse. Am Ende steht oft Frustration, weil A/B-Tests scheinbar „nicht funktionieren“.

Statt sich in Mikrooptimierungen zu verlieren, sollten sich Marketer anfangs auf Tests konzentrieren, die fundamentale Aspekte des Kundenverhaltens untersuchen und das Potenzial für signifikante Verbesserungen bieten. Sei es für den Unternehmenserfolg, das Identifizieren von überflüssigen Marketing-Aktivitäten oder dem Gewinnen tieferer Einblicke in das Verhalten der Zielgruppe.

Hier einige Beispiele für strategischen Tests:

Content-Dichte: Die Kunst der Prägnanz

Können kompakte E-Mails die gleiche oder sogar bessere Wirkung erzielen? Geringere Inhaltsdichte könnte Entscheidungsprozesse vereinfachen und Produktionszeit reduzieren.

Abstimmungsintensive Inhalte: Wert vs. Aufwand

Welchen Mehrwert liefern aufwendig abgestimmte Elemente wie Vorstandseditorials? Eine Straffung könnte Ressourcen freisetzen und Prozesse beschleunigen.

Visuelle Komplexität: Klarheit oder Fülle?

Führen schlichtere, fokussierte E-Mail-Designs zu besserer Performance? Reduzierte visuelle Komplexität könnte die Aufmerksamkeit auf Kernbotschaften konzentrieren.

Produktfokus vs. Lösungsorientierung: Der Schlüssel zur Kundenansprache

Sprechen detaillierte Produktbeschreibungen oder lösungsorientierte Ansätze die Zielgruppe effektiver an? Diese Gegenüberstellung könnte wertvolle Einblicke in Kundenentscheidungen liefern.

Push vs. Pull: Co-Creation statt Einbahnstraße

Erhöht die aktive Beteiligung der Nutzer an der Inhaltserstellung deren Engagement? Umfragen, Quizze & Meinungsbarometer könnten aus passiven Empfängern aktive Teilnehmer machen.

Disclaimer: Es ist wichtig zu beachten, dass dieser Ansatz vor allem für Unternehmen in frühen Stadien des A/B-Testings oder mit kleineren Verteilergrößen relevant ist. In fortgeschrittenen Phasen oder bei großen Verteilern, wenn ein solides Grundverständnis der Zielgruppe besteht, können auch kleinere, inkrementelle Tests wertvoll sein. Diese ermöglichen es, selbst geringfügige Verbesserungen zu messen, die in der Summe einen bedeutenden Einfluss haben können.

Unzureichende Vorbereitung des A/B-Tests

Nachdem wir die Hypothese, die es zu testen gilt, formuliert haben, geht es nun an die Test-Vorbereitung. Leider scheitern viele A/B-Tests genau an diesem Punkt. Sie werden ohne ausreichende Analyse der vorhandenen Daten und ohne gründliche Vorbereitung durchgeführt – frei nach dem Motto „legen wir einfach mal los“. Diese Faktoren sollten Sie vor dem Start beachten:

Erfolgskennzahlen kritisch hinterfragen

Bei der Wahl von Erfolgskennzahlen für A/B-Tests ist es entscheidend, deren Zuverlässigkeit und Messbarkeit zu prüfen. Metriken wie Öffnungs- oder Klickraten können (je nach Device-Mix und Zielgruppe) durch technische Faktoren wie Apples Mail Privacy Protection, blockierten Bilder oder automatische Spam-Checks verzerrt werden. Auch bei der Messung von Conversions muss sichergestellt werden, dass die verwendeten Tracking-Methoden eine präzise Zuordnung ermöglichen.

Historische Erkenntnisse einbeziehen

Vor dem Start eines A/B-Tests ist es wichtig, vorhandene Daten und frühere Erkenntnisse zu analysieren. Dies kann unnötige Tests vermeiden und die Hypothesenbildung verbessern. Wurden in der Vergangenheit ähnliche Tests durchgeführt? Lassen sich bereits vorhandene Erkenntnisse durch Kundenbefragungen oder andere Datenquellen (bspw. Web-Analytics) auf das Design des AB-Tests anwenden?

Grundlegende Aspekte des Testdesigns

Achten Sie auf einen gleichzeitigen Versand beider Varianten bei A/B-Tests, um Zeiteffekte auszuschließen. Begrenzen Sie die Anzahl der Änderungen pro Test, um klare Rückschlüsse ziehen zu können. Analysieren Sie frühere Mailings, um optimale Testzeiten zu bestimmen – beispielsweise, ob die meisten Klicks direkt nach dem Versand oder erst am Abend erfolgen. Diese grundlegenden handwerklichen Aspekte werden in der Praxis teilweise noch immer zu oft übersehen.

Dokumentation sicherstellen

Eine gründliche Dokumentation ist das Fundament jedes erfolgreichen A/B-Tests. Erfassen Sie von Beginn an alle relevanten Details: die genaue Testfragestellung, die Hypothese, die zu testenden Varianten und die geplante Durchführung. Dokumentieren Sie auch Ihre Überlegungen zur Auswahl der Zielgruppe und der Erfolgskennzahlen. Das erleichtert nicht nur die spätere Analyse, sondern fördert auch den Wissenstransfer zwischen Test und innerhalb der Abteilung.

Reproduzierbarkeit & Sekundäreffekte werden ignoriert

A/B-Tests können Quick Wins durch die Fokussierung auf direkt messbare Ergebnisse liefern. Allerdings besteht die Gefahr, dabei zwei wichtige Aspekte zu übersehen:

Reproduzierbarkeit sicherstellen

Da E-Mail-Tests häufig auf einem einmaligen Versand basieren, ist es ratsam, entscheidende Tests zu wiederholen, um die Konsistenz der Ergebnisse sicherzustellen und statistische Zufälle auszuschließen. Diese Wiederholungen sollten idealerweise zu unterschiedlichen Zeitpunkten durchgeführt werden, um saisonale Effekte oder temporäre Anomalien zu berücksichtigen.

Auch auf Sekundärmetriken achten

Der Fokus auf eine einzelne primäre Metrik kann täuschen. Eine Verbesserung in einem Bereich führt nicht automatisch zu besseren Gesamtergebnissen. Daher ist es entscheidend, den gesamten Prozess von der Öffnung bis zur Conversion zu betrachten. Sekundärmetriken helfen dabei, ein umfassenderes Bild der Kampagnenleistung zu erhalten und mögliche unbeabsichtigte Konsequenzen zu identifizieren.

Primär- vs. Sekundärmetriken – Ein Beispiel:

Öffnungsrate: Personalisierung mit dem Namen im Betreff kann die Öffnungsrate steigern, aber führt sie auch zu mehr Engagement? Beispiel: Ein personalisierter Betreff mag mehr Öffnungen generieren, aber wenn der Inhalt gleich bleibt, bringt dies keinen Uplift bei den Klicks.

Klickrate: Eine kompakte E-Mail mit kurzen Produktbeschreibungen und „Mehr lesen“-Links erhöht die Klickrate. Allerdings bleibt die Conversion-Rate unverändert. Dies könnte darauf hindeuten, dass wichtige Informationen auf der Landingpage fehlen oder nicht optimal präsentiert werden

Conversion-Rate: Gesteigerte Conversion-Raten sind das Ziel, aber führen sie tatsächlich zu profitableren Kundenbeziehungen? Beispiel: Hohe Rabatte können kurzfristig Conversions steigern, langfristig aber die Profitabilität gefährden.

Zudem ist es wichtig, Gewöhnungseffekte zu bedenken: Was beim ersten Mal gut funktioniert, kann mit der Zeit an Wirkung verlieren. Häufiges Beispiel hierfür sind Emojis in Betreffzeilen – initial können sie die Öffnungsraten steigern, doch bei häufiger Nutzung kann dieser Effekt nachlassen, bis der ursprüngliche Uplift sich der Null nähert.

Fehlende Beachtung statistischer Grundlagen

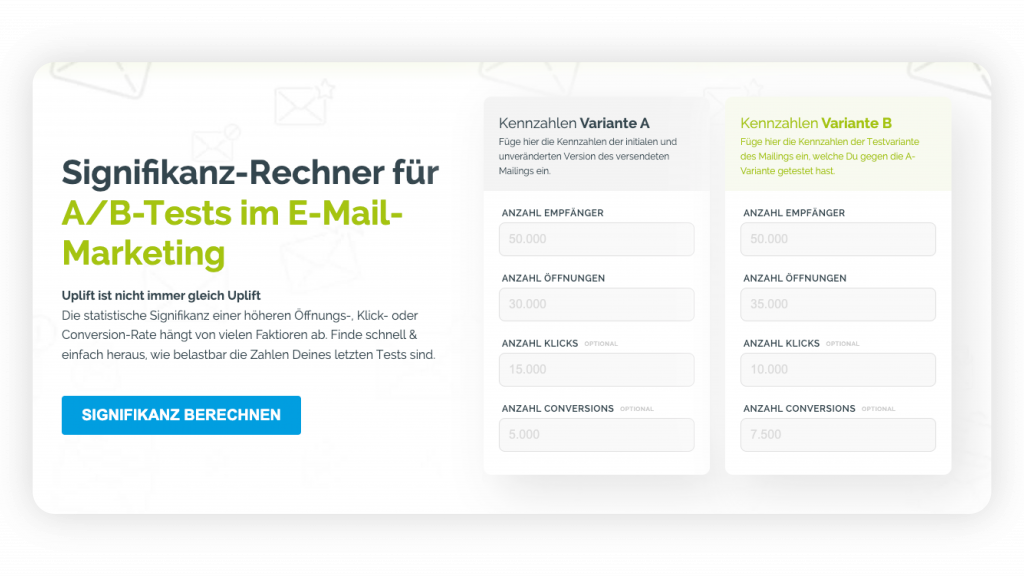

Die Berechnung statistischer Signifikanz und die Wahl angemessener Stichprobengrößen sind entscheidend für aussagekräftige A/B-Tests, werden aber oft unterschätzt. Diese vermeintlich trockenen Aspekte sind der Schlüssel zu validen Ergebnissen und verhindern Fehlinterpretationen, die zu falschen Entscheidungen führen können.

Stichprobengröße und Signifikanz

Bei kleinen Verteilern kann eine Veränderung von 1% in der Klickrate zufällig sein und keine echte Verbesserung darstellen. Bei Millionen von Empfängern hingegen kann dieselbe 1%ige Veränderung hochsignifikant sein und Tausende zusätzliche Klicks bedeuten. Je größer Ihre Stichprobe, desto kleinere Unterschiede können Sie zuverlässig erkennen. Allerdings bedeutet dies auch, dass Sie bei großen Verteilern besonders vorsichtig sein müssen, nicht jede kleine Veränderung als bedeutsam zu interpretieren.

Signifikanz vs. Relevanz

Statistische Signifikanz bedeutet nicht automatisch praktische Relevanz. Bei sehr großen Stichproben können selbst winzige Unterschiede statistisch signifikant werden, ohne einen echten Geschäftswert zu haben. Beispielsweise könnte eine Änderung der Betreffzeile zu einer statistisch signifikanten Steigerung der Öffnungsrate um 0,1% führen. Ist dieser Unterschied aber den Aufwand wert? Es ist wichtig, neben der Signifikanz auch die absolute Größe des Effekts und dessen praktische Auswirkungen zu betrachten.

Konfidenzintervalle

Stellen Sie sich vor, Sie messen die Temperatur mit einem Thermometer, das nicht ganz genau ist. Statt zu sagen „Es sind genau 20°C“, würden Sie eher sagen „Es sind etwa 20°C, vermutlich zwischen 19°C und 21°C“. Bei A/B-Tests funktionieren Konfidenzintervalle ähnlich. Anstatt zu behaupten „Die neue E-Mail-Version ist genau 5% besser“, sagen Sie „Die Verbesserung liegt wahrscheinlich zwischen 2% und 8%“ – dieser Bereich wäre das Konfidenzintervall. Ein Konfidenzintervall wird berechnet, indem man den Mittelwert der Stichprobe bestimmt und dann einen Bereich um diesen Wert legt, der die mögliche Schwankung berücksichtigt. Die Größe dieses Bereichs hängt von der Streuung der Daten, der Stichprobengröße und dem gewünschten Konfidenzniveau ab.

A/A-Tests

Bei einem A/A-Test werden zwei identische Versionen gegeneinander getestet. Logischerweise sollte es keine signifikanten Unterschiede geben, da die Varianten gleich sind. Der Wert liegt in der Einsicht, die diese Tests bieten: Sie zeigen die natürliche Variabilität in Ihren Daten. Wenn A/A-Tests regelmäßig „signifikante“ Unterschiede zeigen, deutet dies auf Probleme in Ihrem Testaufbau hin. Nicht zuletzt kalibrieren sie Ihr Verständnis für echte Effekte. Wenn Sie wissen, wie viel Variation normal ist, können Sie besser einschätzen, wann ein Unterschied in A/B-Tests wirklich bedeutsam ist.

P-Wert: Signifikanz oder Zufall?

Der P-Wert gibt an, wie wahrscheinlich es ist, dass Ihr Testergebnis zufällig zustande gekommen ist. Je kleiner der P-Wert, desto unwahrscheinlicher ist es, dass der beobachtete Unterschied zwischen A und B zufällig ist. Üblicherweise gilt ein Ergebnis als „statistisch signifikant“, wenn der P-Wert kleiner als 0,05 (5%) ist. Dies hilft Ihnen einzuschätzen, ob die Unterschiede in Ihrem A/B-Test bedeutsam sind oder ob sie einfach durch Zufall entstanden sein könnten.

Z-Score: Ausreißer oder Normalfall?

Der Z-Score hingegen zeigt, wie weit Ihr Ergebnis vom Durchschnitt entfernt ist. Ein höherer Z-Score bedeutet, dass Ihr Ergebnis weiter vom Erwarteten abweicht und daher wahrscheinlich nicht zufällig ist. Diese Metrik ergänzt den P-Wert und bietet eine weitere Perspektive auf die Signifikanz Ihrer Testergebnisse.

Sobald diese Grundlagen beherrscht und handwerkliche Stolpersteine überwunden werden, eröffnen sich Möglichkeiten für fortgeschrittenere Testmethoden. Mit solidem Fundament eröffnen sich Möglichkeiten für fortgeschrittene Methoden wie multivariates Testing, Langzeittests mit Holdout-Gruppen und die präzise Analyse inkrementeller Veränderungen.

Eines sollte aber nicht vergessen werden: A/B-Testing ist nur eines der Werkzeuge, welche den Weg ebnen, eine Kultur der datengetriebenen Entscheidungsfindung im Unternehmen zu etablieren. In diesem Umfeld werden Testergebnisse nicht nur generiert, sondern gründlich analysiert, kontextualisiert und in konkrete, wertschöpfende Maßnahmen umgesetzt.